Wie beim letzten Mal angekuendigt, werden heute die Archipele reproduziert … øhm … das war ’n Spoiler.

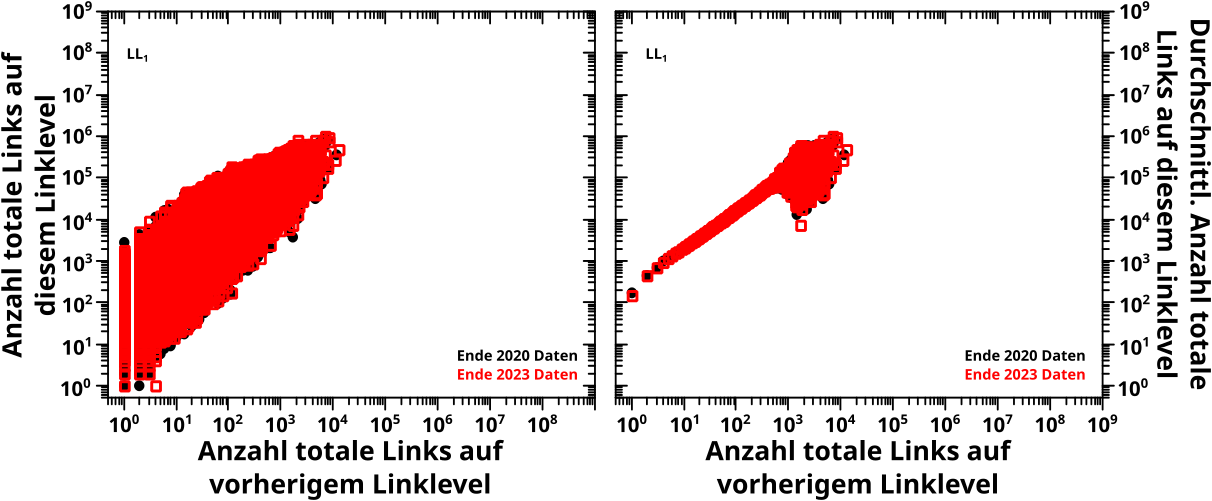

Damals bin ich ueber dieses Phaenomen eher zufaellig gestolpert und habe ’ne ganze Menge draus gemacht. Heute schau ich mir nur das Gesamtergebniss an und gehe nicht nochmal auf das ein, was mich vor so vielen Beitraegen auf die Spur der Archipele brachte (zur Erinnerung (auch wenn das hier irrelevant ist): der erste Balken im hier zu sehenden Diagramm war zu hoch und das musste erklaert werden).

Natuerlich hab ich das Programm mit dem ich damals die Archipelseiten fand nochmal neu geschrieben. Die Verbindung zur Summe ueber alle Linklevel (cf. der letzte Beitrag) hatte ich ja erst nach den Archipelen entdeckt. Und OMG war das nøtig! Da drin steckte naemlich so viel was zum urspruenglichen Zweck der Untersuchungen (der Ursprung des zu hohen Balkens) beitragen sollte … und so viel Spaghetticode Experimentalcode in dem Zeilen an Stellen auszukommentieren waren, um andere Sachen an anderen Stellen anders zu bewirken.

Wieauchimmer, das ist jetzt ein feines, rekursives Programm, was ich so auch anderen Leuten zeigen kann … zugegeben, rekursiv war es notwendigerweise auch schon vorher … aber das haett ich keinem zeigen wollen.

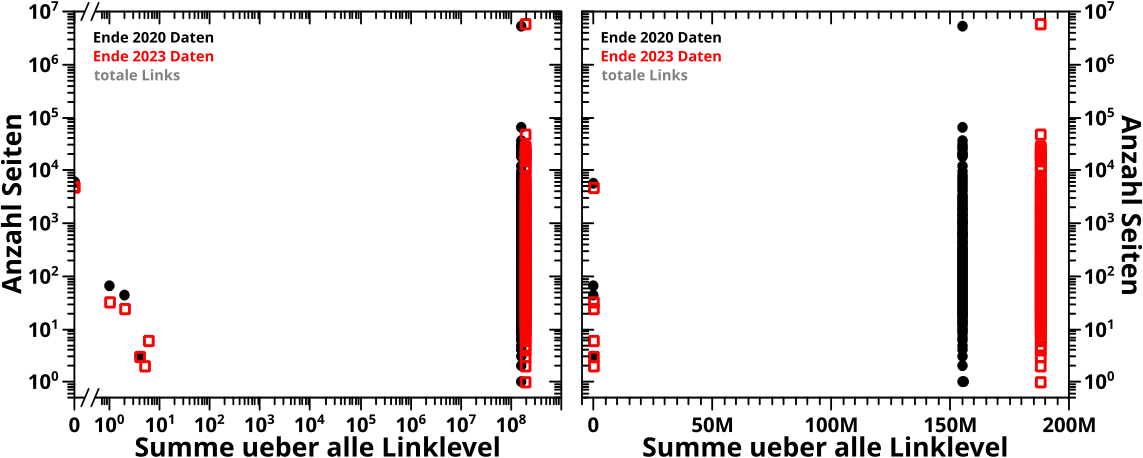

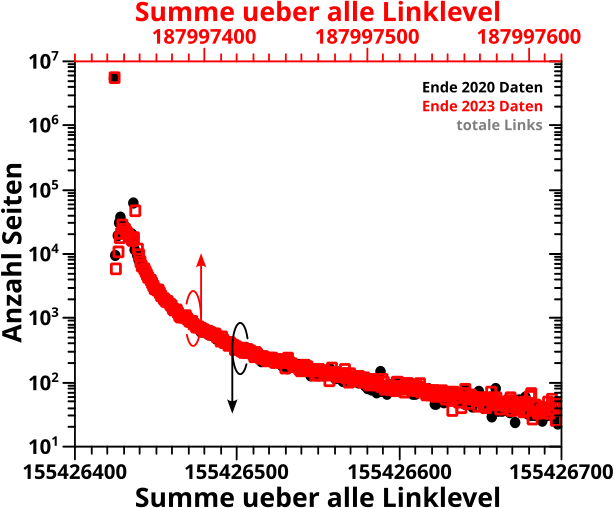

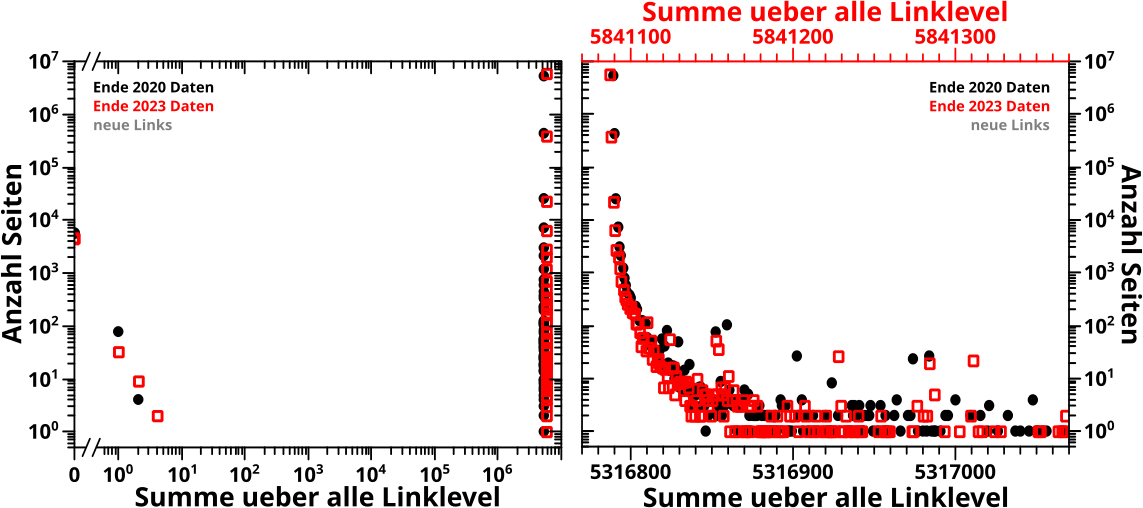

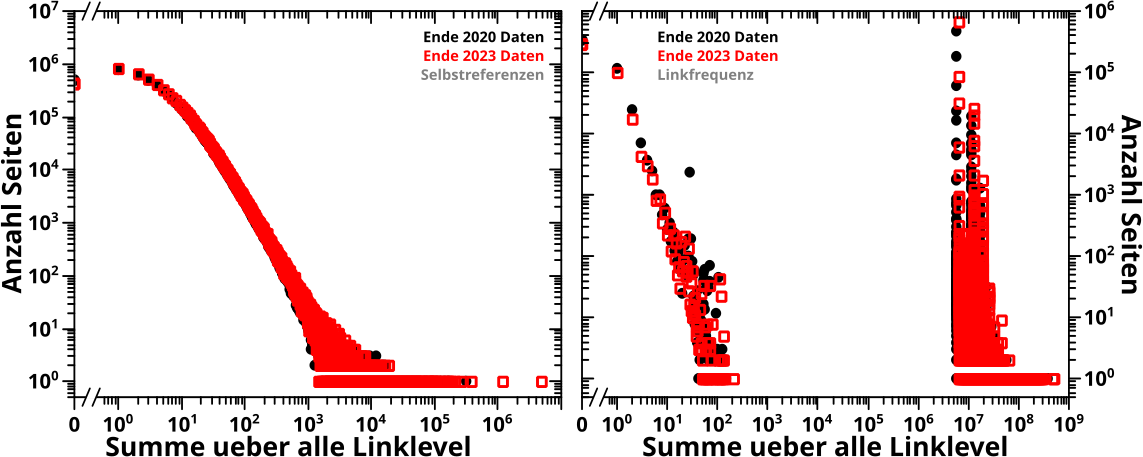

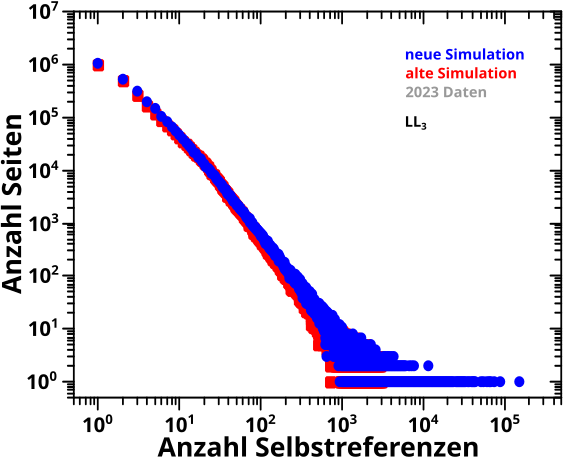

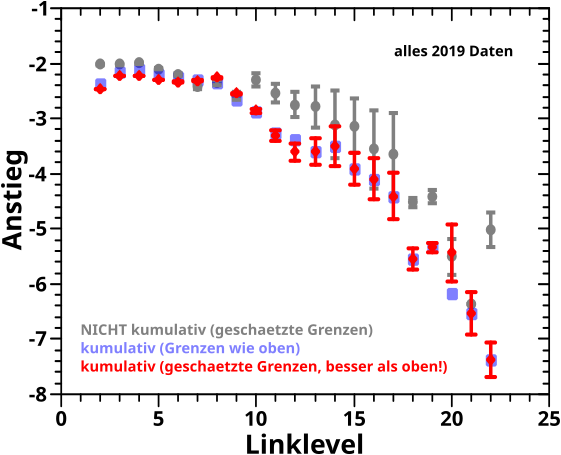

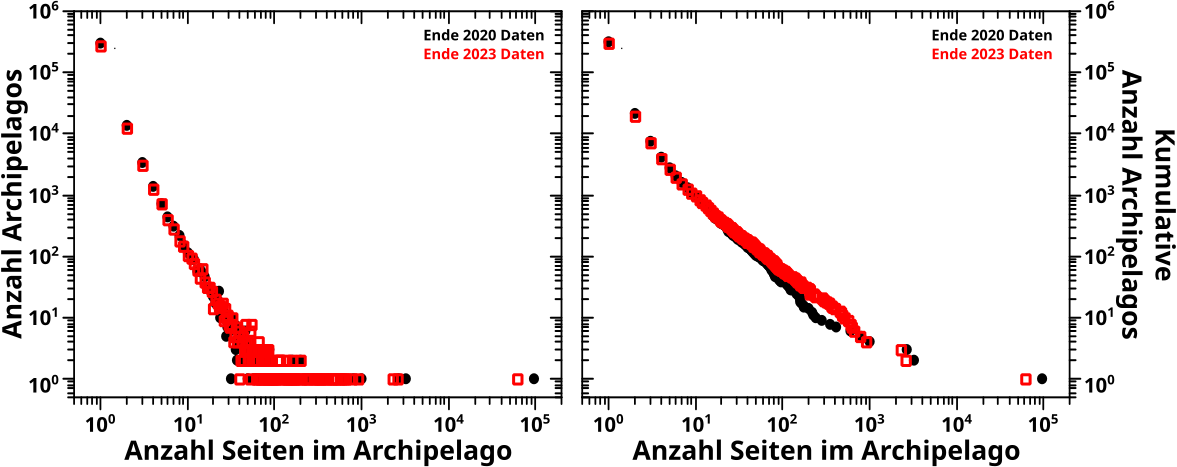

Und hier ist das einzige Resultat von Interesse — das Histogramm bzgl. der Grøsze der Archipele der 2020- und 2023-Daten:

Zunaechst ist zu sagen, dass die Anzahl der Archipelagoseiten sich von 481.522 auf 428.315 reduziert hat. Das ist eine Reduktion um 11 % und das find ich schon signifikant. Insbesondere in Anbetracht dessen, dass die Wikipedia deutlich gewachsen ist; das ergibt also eine noch grøszere relative Reduktion.

Die Anzahl der Seiten die ein „Archipel“ nur aus sich selbst bilden reduzierte sich von 321.161 auf 297.798. Alle anderen Seiten befinden sich in Archipelen die mehr als eine Seite enthalten und davon gibt es in den 2020-Daten 21.073 und in den 2023-Daten 19.722 … deren Grøszeverteilung sieht man in den beiden Diagrammen.

Trotz des doch deutlichen Unterschieds in der Anzahl der Archipelseiten, ist die „Dynamik“ im Wesentlichen die Gleiche. Im ueblichen, doppellogarithmischen Diagramm sieht man keinen signifikaten Unterschied zwischen den beiden Datensaetzen. Bei der kumulativen Darstellung hingegen durchaus. Im mittleren Bereich weichen die 2023-Daten etwas nach oben ab. Das ist ja interessant … da sind also ’n paar grøszere Archipele noch ein bisschen gewachsen … oder neue Archipele mit aehnlicher Grøsze sind dazu gekommen. Aber wer im Detail wissen will was da passiert ist, der sollte das selber untersuchen.

Damals hatte ich mir dann auch noch zwei lange Ketten von „Inselspruengen“ angeschaut. Das hab ich auch nochmal neu programmiert (auch rekursiv), aber dieses Mal mit dem Ziel die laengsten møglichen Ketten von Spruengen zwischen „Inseln“ (vulgo: Seiten) eines Archipels zu finden (ohne auf bereits besuchte Inseln zurueck springen zu muessen). Das ist auch ein rekursiver Prozess … und nach vielen Tagen und Naechten sind bei den 2020-Daten drei, und bei den 2023-Daten zwei Archipele immer noch nicht vollstaendig nach der laengsten Ketten von Spruengen durchsucht. Auf die mathematischen bzw. programmatischen Gruende dafuer geh ich hier nicht naeher ein. Mein Bauchgefuehl sagt mir aber, dass das nicht viel ausmachen sollte und die soweit gefundenen laengsten Ketten von Spruengen mindestens die zweitlaengsten Ketten sind.

In den 2020-Daten besteht die laengste (gefundene) Kette aus 61 Spruengen, auf einem aus 88 Seiten bestehenden Archipel,

Angefangen bei der Seite List of artists with the most UK top-ten albums, welche dann die Seite Lists of UK top-ten albums zitiert, welche dann die Seite List of UK top-ten albums in 2020 zitiert, welche dann die Seite List of UK top-ten albums in 2020 zitiert, welche dann die Seite List of UK top-ten albums in 2018 zitiert, welche dann … … … die Seite List of UK top-ten albums in 1962 zitiert und dann gibt’s nichts mehr wo man hinspringen kønnte, wo man noch nicht war (auszer raus aus dem Archipel, ins grosze weite Wikipedia Linknetzwerk).

Obacht, bitte nicht vergessen: Archipelseiten werden nicht dadurch definiert, dass sie nix anderes zitieren, sondern dass sie aus dem groszen weiten Wikipedianetzwerk nicht zitiert werden (sondern allerhøchstens von anderen Archipelseiten).

Ebenso nicht vergessen: es darf nicht zurueckgesprungen werden bei diesem Spiel. Bspw. finden sich auf der Lists of UK top-ten albums Seite bereits alle Jahre, aber weil ich nicht zurueck darf, muss ich danach jedes Jahr nacheinander „anspringen“.

Bei den 2023-Daten … ist das immer noch die laengste Kette, nur dass dort dann 6 zusaetzliche Spruenge (zu drei spaeteren und 5 frueheren Jahren, bei gleichzeitigem Herausnehmen der ersten beiden Seiten der 2020-Kette) dazukommen.

Die damals erkannte Jahreskette der Waterford Senior Hurling Championship ist uebrigens weiterhin die zweitlaengste Kette, sowohl in den 2020-Daten (39 Spruenge), als auch in den 2023-Daten (46 Spruenge).

Damals hatte ich die aber entdeckt, weil diese Jahreskette wirklich nur eine lange Kette von Spruengen von Insel zu Insel ist, waehrend die Jahre der UK top-ten albums sich vermutlich untereinander zitieren.

Oder anders: Letzteres sind eher ein „Knaeuel“ als eine Kette und mein Algorithmus springt die Inseln nur bestmøglich ab. Deswegen wurde ich damals auf die Hurling Championship Jahreskette aufmerksam, einfach weil die leichter zu erkennen war.

So … das soll nun aber reichen. … Ach ja … Archipele erfolgreich reproduziert :)