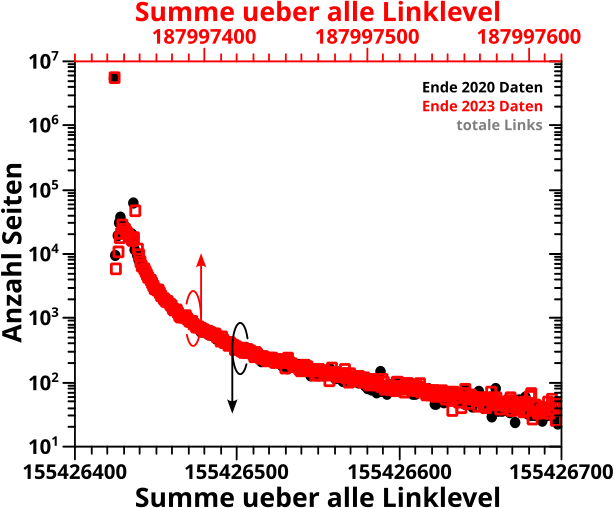

Endlich bin ich bereit, all das in den letzten beiden Beitraegen Geschriebene, in ein einziges (bewegtes) Bild zu kondensieren. Hier ist es, …

… das Diagramm, fuer das ich die meiste Zeit brauchte. Nicht nur innerhalb dieses Projekts, sondern auch bzgl. der tausende von Diagramme die ich in meinem ganzen Leben bisher erstellt habe. Mehr als 12 Stunden Arbeit stecken hier drin. Und das zaehlt nicht mal mit, dass ich die linke Seite (fast) komplett von vorher recyceln konnte. Ich gebe zu, dass die Verantwortung bzgl. dieses immensen Zeitaufwands komplett bei mir und meiner pedantisch Art liegt … aber ich møchte halt jede Null und jeden Tick genau ausgerichtet (und abgerundet) haben. Und weil’s nur ein Diagramm ist, mit vielen verschiedenen Arbeitsschritten, war’s auch nicht sinnvoll das zu automatisieren (wie beim letzten Mal).

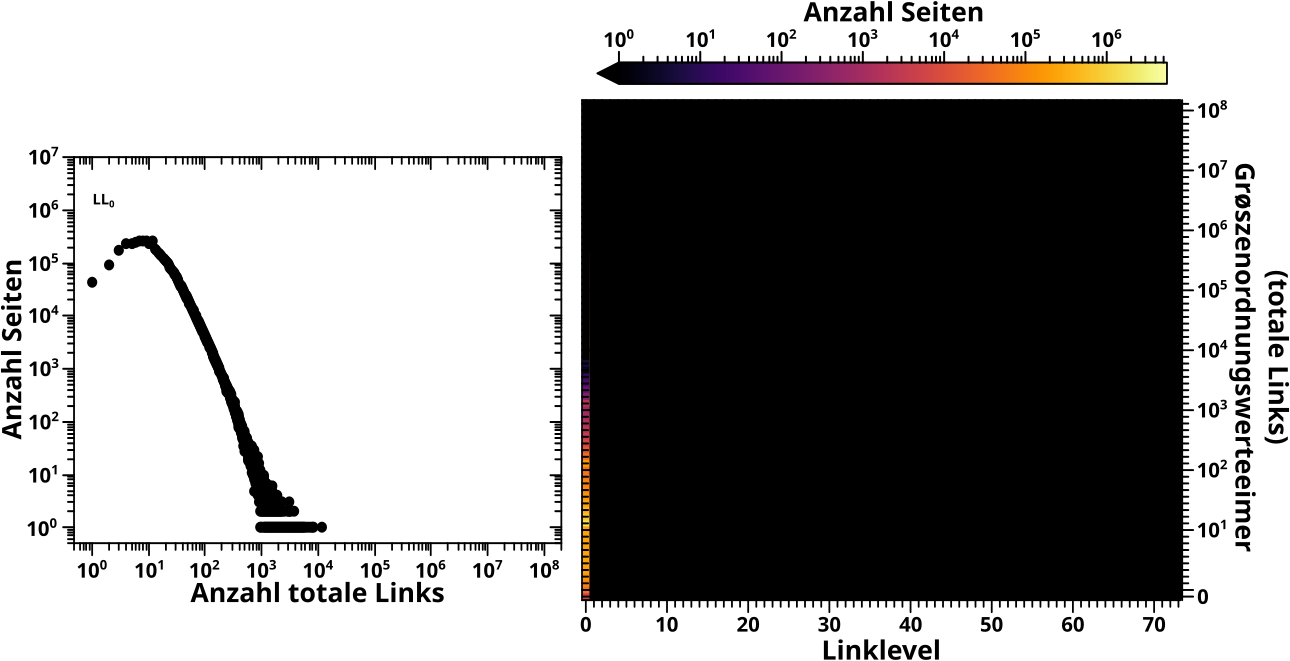

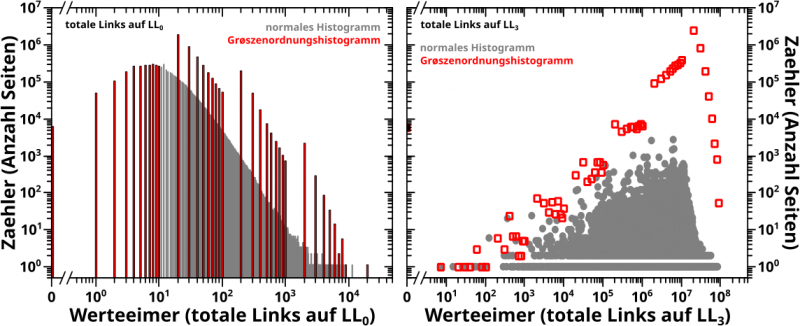

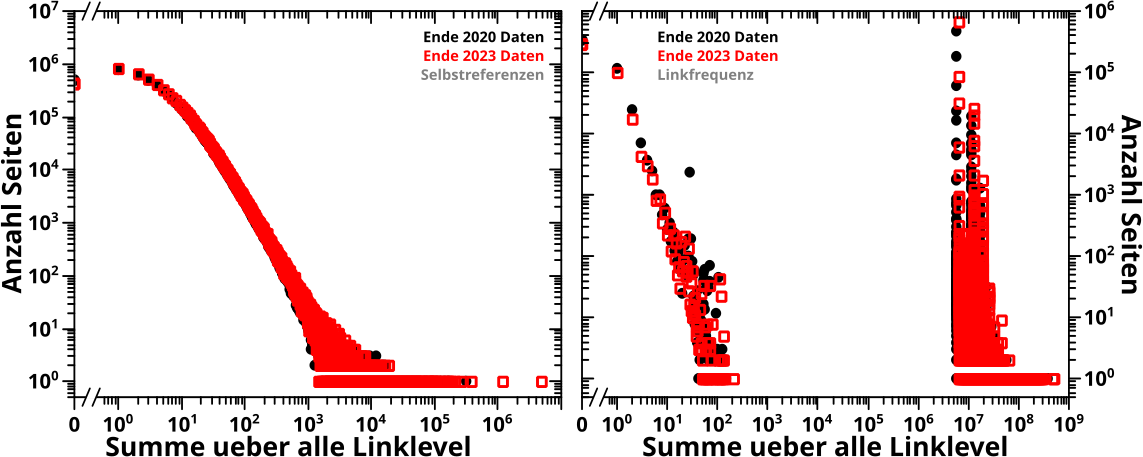

Wieauchimmer, in dem Bild sieht man das vormals beschriebene Prinzip anhand der Entwicklung der totalen Links aller Seiten (die linken Diagramme) der 2020-Daten, uebertragen auf eine Grøszenordnungsheatmap (rechte Seite).

In der Heatmap ist die „zeitartige“ Entwicklung, also die unterschiedlichen Linklevel, welche in den linken Diagrammen nur eins nach dem anderen zu sehen sind, auf der Abzsisse abgetragen. Die Abzsisse der linken Diagramme wird in Grøszenordnungseimer „transformiert“ und dann auf die Ordinate in der Heatmap uebertragen. Und die Ordinate der linken Histogramme wird so wie sie ist in die dritte Dimension, die Falschfarbenskala transformiert.

Natuerlich ist die Heatmap eigentlich sofort da, aber das ist ja nicht der Fall mit der animierten Sequenz von Histogrammen auf der linken Seite. Deswegen ist der rechte Teil der (jeweiligen) Heatmap schwarz. Ebenso schrieb ich:

[…] seien wir ehrlich, wenn die letzten Frames des bewegten Bildes gezeigt werden, hat man (nicht nur) die Details der ersten Frames schon vergessen […].

Diesen „Effekt“ versuche ich durch den „verblassten“ linken Teil der (jeweiligen) Heatmap darzustellen — alle Informationen sind eigentlich da, aber irgendwie nicht so klar.

Alles in allem: eine voll geile grafische Darstellung des Prinzips der Grøszenordnungshistogramme in Heatmaps. Fetzt voll wa!

… … …

… … …

… … …

Genug gezeappelt, schlieszlich hab ich all das ja nur geschrieben um genau davon weg zu kommen und nur noch das hier zeigen zu kønnen:

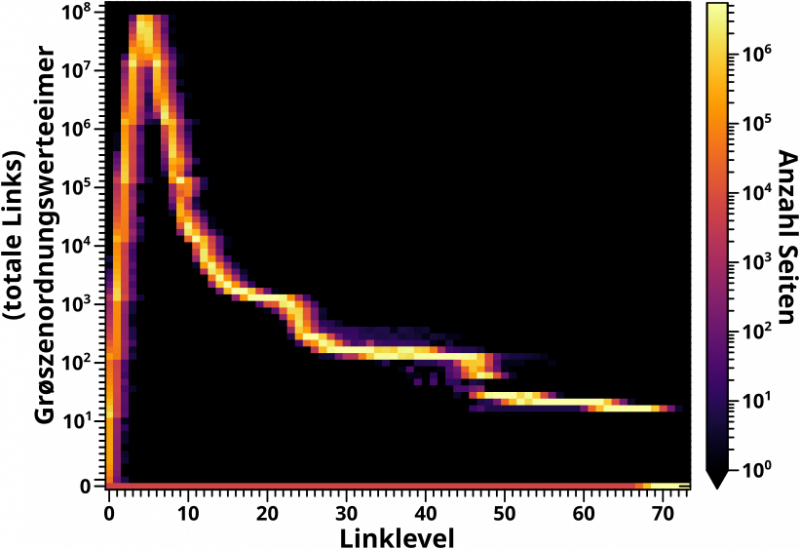

Die beim letzten Mal beschriebenen „Stufen“ sind natuerlich nur dann zu sehen, wenn sich das Histogramm auch wirklich ueber mehrere Grøszenordnungen ausdehnt. Deswegen sieht man dieses Phaenomen wirklich gut nur bei den Streifen der ersten drei, vielleicht vier Linklevel. Zum Beispiel bei LL1, von unten nach oben gehend, ist der Abschnitt zwischen 100 und 1000 recht einfarbig. Bei 2000 dann nimmt die „Intensitaet“ des Streifens abrupt zu um bis 10-tausend wieder abzunehmen. Bei 20-tausend (und weniger stark nochmal bei 200-tausend), passiert das Gleiche nochmal. Das sind besagte „Stufen“.

Die besprochene Generalisierung dieses Phaenomens (Zunahme des „Grøszenordnungssignals“ nicht nur an einer „Stufe“ sondern ueber mehrere Werteeimer), sieht man bei genauem Hinschauen an den oberen Enden der Streifen fuer LL4 und LL5.

Interesseant sind zwei neue Beobachtungen in der Heatmap, die so nicht so leicht in den animierten (normalen) Histogrammen zu sehen sind und die ich auch nicht erwartet hatte, aber haette erwarten kønnen.

Zum einen gibt es in der Heatmap selber „Stufen“ einer anderen Art im Signal. Ich meine die abrupte Abschwaechung des Signals von LL22 zu LL25 und dann nochmal von LL44 zu LL49.

Das ist zum Glueck leicht zu erklaeren, insb. mit Blick zurueck auf die animierten Histogramme. Ab LL12 ist dier ueberwiegende Teil des Signals in den Bereich der „Tausender Werteeimer“ zu finden. Das Signal hat also Werte von 10-tausend bis 2000. Dieser Bereich der „Tausender Werteeimer“ wird innerhalb von 10 Linkleveln (eben bis LL22) „ueberwunden“. Oder anders: die Dynamik des Prozess durchschreitet mit nur zehn Schritten die Werte von 10-tausend bis 2000. Diese Dynamik wird langsamer je naeher es der 2000 kommt … aber letztlich „knallt“ es mit „hoher Geschwindigkeit“ in den Bereich der „HUNDERTER Werteeimer“. Aber von 1000 zu 900 sind nur einhundert Werte zu „durchschreiten“. Wenn der Prozess da also mit einer „Geschwindigkeit“ von (ich sag jetzt mal) „500 Werte pro Linklevel“ „draufknallt“, dann durchlaeuft der Prozess die Werteeimer von 1000 bis ca. 500 natuerlich in Null komma Nix … oder genau gesagt: innerhalb von nur zwei Linkleveln. Das fuehrt zu der zu sehenden „Stufe“ im Signal. Dass es ueberhaupt zwei Linklevel braucht liegt daran, weil die Dynamik rapide langamer wird.

Das Gleiche passiert beim Uebergang zu den „Zehner Werteeimern“, weswegen dort eine weitere „Stufe“ in der Heatmap zu sehen ist.

Die zweite neue Beobachtung ist innerhalb dieser zweiten „Stufe“ zu sehen. Dort scheint das Signal sich in zwei Bereiche aufzuspalten. Wenn man genau hinschaut, dann sieht man das (sehr schlecht) in den normalen, animierten Diagrammen. Als ich das reproduziert hatte, zeigte ich ein Extrembeispiel dieses Phaenomens in den 2023-Daten in einem gesonderten Diagramm. Aber in den Histogrammen der 2020-Daten ist mir das bisher nicht aufgefallen, eben weil die Datenpunkte dort so dicht beeinander liegen, dass ich das buchstaeblich nicht gesehen habe.

Die neue Methode der Darstellung von Information enthuellt noch mehr Sachen die bisher „versteckt“ waren als angenommen. Fetzt wa!

So, das soll reichen fuer heute. Beim naechsten Mal dann endlich zurueck zur Reproduktion.

Ach so … eins noch: die Ordinate der Heatmap hat _zwei_ lange Striche am unteren Ende. Einen fuer „Werteeimer 0“ und einen fuer „Werteeimer 1“. Normalerweise achte ich pedantisch (siehe oben) darauf, dass sowas nicht passiert.

Hier ist das aber volle Absicht, denn die Null gibt es in logarithmischen Diagrammen ja gar nicht … bzw. liegt die bei minus Unendlich. In normalen Diagrammen hab ich die dazugehørenden Datenpunkte frueher erst einfach reingepackt und gesagt, dass die einen Wert von Null haben. Seit einger Zeit unterbreche ich die Achse an der entsprechenden Stelle. Bei Grøszenordnungshistogrammen ist das aber kein Problem mehr, denn der Wert Null bekommt einfach seinen eigenen Werteeimer.

Nun ist es aber so, dass die Ordinate immer noch ’ne „logarithmische (numerische) Bedeutung“ hat. Und da wird dem Wert Eins ein langer Strich zugeordnet. Das wollte ich gerne beibehalten. Dem „Werteeimer 0“ einen kurzen Strich zu geben fuehlte sich aber auch nicht richtig an, denn das kommt einer „Verlaengerung“ der Achse mit logarithmischer Bedeutung zum Wert Null (was ja nicht geht) zu nahe. Deswegen lasse ich den mit Absicht etwas herausstechen (Wortspielkasse); auch um auf die Andersartigkeit dieser Art der Darstellung von Information hinzuweisen.