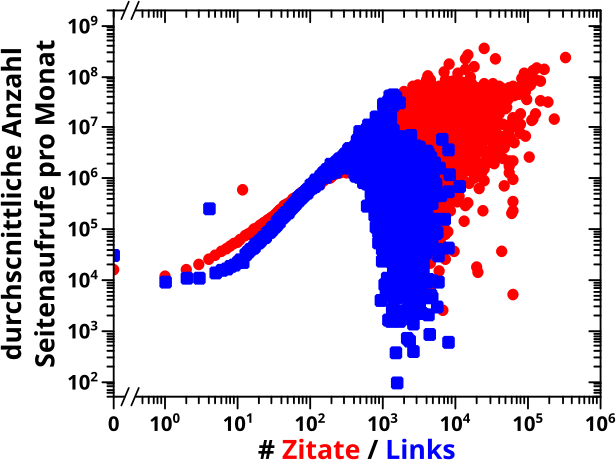

Beim letzten Mal stellte ich eine neue Datenquelle vor, welche die Anzahl der Seitenaufrufe pro Tag fuer jede Wikipediaseite hat. Das ist von Interesse, denn in den Analysen der vorhergehenden Jahre behauptete ich oft, dass i.A. Seiten mit mehr Zitaten populaerer sind. Das ist durchaus eine plausible Behauptung, allein schon weil oefter zitierte Seiten eine grøszere Chance haben angeklickt zu werden, einfach weil die øfter von Nutzern gesehen werden. Der Quelltext enthaelt allerdings keine Information darueber, dass das auch „in Echt“ (also extern und nicht nur via internen Zitaten von einer Seite zur naechsten) gilt.

Die neuen Daten erlauben mir das nun direkt zu testen indem man sich die Aufrufe einer Seite in Abhaengigkeit von der Anzahl der (Wikipedia internen) Zitate (oder Links) anschaut.

Das ist das Prinzip, aber natuerlich ist das nicht ganz so einfach. Zunaechst einmal muss man die beim letzten Mal erwaehnten natuerlichen und unnatuerliche Artefakte in den Daten „rausmitteln“. Das ist einfach, denn dafuer muss nur die durchschnittliche Anzahl an Seitenaufrufen pro Monat berechnet werden (fuer jede Seite). Es ist leicht einzusehen, dass das nix am allgemeinen Prinzip aendert, die Interpretierbarkeit des Diagramms hingegen deutlich erleichtert.

Ich vermutete aber, dass das immer noch nicht ausreicht, denn ich ging davon aus, dass selbst die durchschnittlichen monatlichen Seitenaufrufe massiv streuen. Oder anders: ich erwartete eine dichte Punktwolke ohne viel Struktur, wie schon bei der Abhaengigkeit der Anzahl der Links von der Anzahl der Zitate von „damals“. Die Løsung lag (wieder) in einer gruppenweise Mittelung der durchschnittlichen Seitenaufrufe. „Gruppenweise“ bedeutet hier (wieder), dass alle Seiten die eine gegebene Anzahl an Zitaten / Links haben eine Gruppe ausmachen. Die durchschnittlichen Seitenaufrufe aller Mitglieder der Gruppe wurden dann gemittelt.

Das sagt nicht mehr unbedingt viel ueber einzelne Seiten aus, denn die Information die in der Streuung der Werte liegt geht komplett verloren. Aber individuelle Seiten interessieren mich ohnehin nicht wirklich. Diese Herangehensweise erhøht die Interpretierbarkeit allerdings deutlich, wenn man auf allgemeine Erwartungen (oder Verhalten) bei einer gegebenen Situation (die Anzahl der Zitate / Link) aus ist.

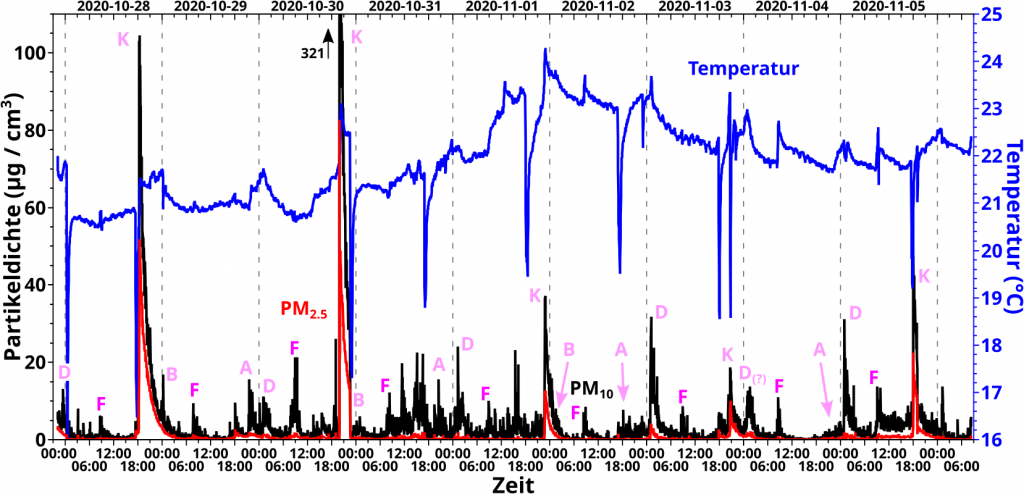

Und hier ist nun endlich das Diagramm:

Voll super wa! Fuer bis zu ca. 1000 Zitate / 500 Links verhaelt sich die Anzahl der durchschnittlichen monatlichen Seitenaufrufe nach einem maechtigen Gesetz. Danach gilt das nicht mehr i.A. denn die Punkte streuen zu sehr. Letzteres liegt daran, weil ich bei sehr vielen Zitaten / Links nicht mehr genuegend Seiten fuer eine gute Statistik habe. Die obige Behauptung ist aber weiterhin i.A. gueltig, denn Seiten mit mehr als ca. 1000 Zitaten / 500 Links halten sich eher im oberen, als im unteren Teil des Diagrams auf (und bei logarithmischer Achse „haut das doppelt rein“ … streng genommen zehnfach, denn es ist ja ’ne logarithmische Achse).

Natuerlich haette ich die blauen Punkte gar nicht einzeichnen muessen, denn wir wissen ja, dass die Anzahl der Links nach einem maechtigen Gesetz von der Anzahl der Zitate abhaengt. Ich wollte das aber zeigen, denn besagte Abhaengigkeit fuehrt zu unterschiedlichen Anstiegen der blauen und roten „Kurve“.

So … viel mehr gibt’s dazu nicht zu sagen. Es ist fein zu sehen, dass die plausible Behauptung tatsaechlich stimmt.

Damit werde ich dann ab dem naechsten Mal die Reproduzierbarkeit der Ergebnisse angehen … nach ueber drei Jahren wird das dann aber zu einem unregelmaeszigeren Publikationsrhytmus fuehren, denn das mache ich zusammen mit dem neu schreiben der Analyseprogramme und das dauert ’ne Weile.