Die Simpsons waren in den 90’er Jahren des vorigen Jahrhunderts der Knaller! Und als die dann auch als Comic heraus kamen hab ich den natuerlich gekauft. Von allen Comics die ich habe, kønnten die ersten Ausgaben einige der extrem wenigen Comics sein die ich besitze, welche heutzutage einen (deutlich, wenn auch nicht gigantisch) høheren Wert haben … wenn ich die damals super ordentlich behandelt haette … hab ich aber nicht … und das ist auch nicht so schlimm, denn Comics sollten gelesen werden und nur in Ausnahmefaellen in versiegelten Plastikschalen ihr Dasein fristen.

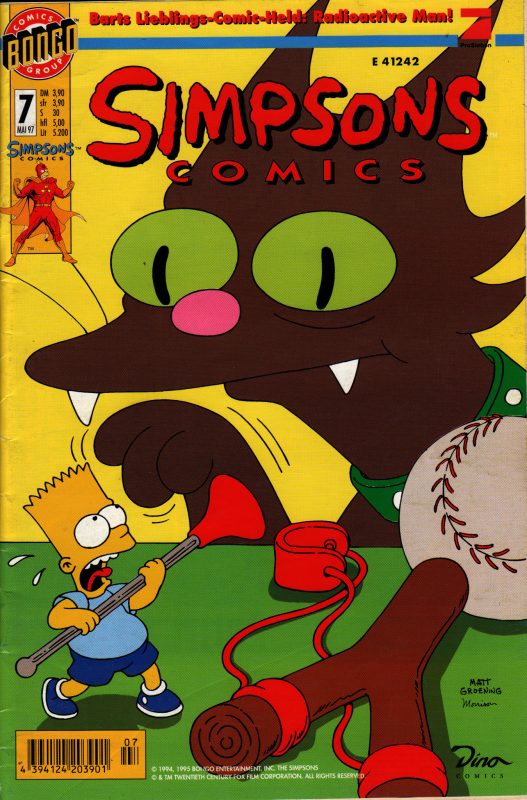

Soweit dazu, nun zu etwas ganz Anderem. Mir ist es schwer gefallen, Cover fuer den heutigen Beitrag zu finden, die ich ohne weitere Worte einfach so „reinklatschen“ kønnte, weil sie in ihrer Form fuer sich stehen. Die Cover der Simpsons Comics sind zwar immer passend und gut, haben bei mir aber nicht so’n „COOL“-Gefuehl verursacht (wie bspw. das hier). Aus der „Not“ heraus nahm ich dann solche, die ein paar der Dinge illustrieren die ich hier ansprechen werde.

Genug der Vorrede!

Wie erwaehnt, waren Die Simpsons super populaer als sie urspruenglich erschienen und es gibt genuegend Untersuchungen und Aufsaetze die erklaeren warum (siehe bspw. hier … ich hab das nicht gelesen, der Titel klingt aber interessatn und das poppte auf der ersten Seite einer schnellen Suche auf). Relevant finde ich hier, dass ich schon damals irgendwie nicht das URST lustig fand, was alle anderen URST lustig fanden. Homer war witzig, ich fand ihn aber jetzt nicht sooo witzig. Dito bzgl. Bart oder Itchy & Scratchy. Insb. bei Letzteren tat mir die arme Katze voll leid …

… und dass ich mich nicht wirklich mit Bart identifizieren konnte muss wohl nicht weiter erklaert werden.

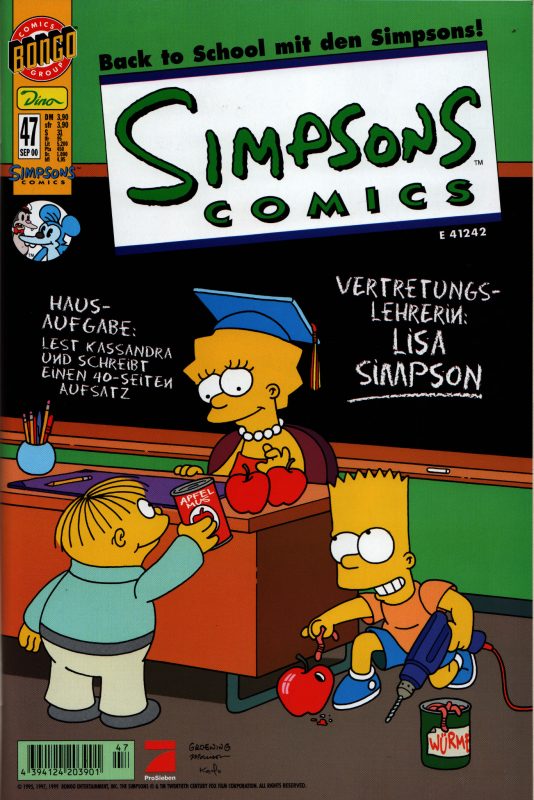

Seine Schwester Lisa hingegen verdient etwas mehr Worte, denn damals fand ich die langweilig … aber beim nochmaligen Lesen fand ich sie (und Marge) in der ganzen Serie am Besten. Das liegt daran, dass diese beiden Figuren die „Vernuenftigen“ sind. Lisa versucht rational zu handeln und die Welt aktiv zu verbessern, trotz der ewigen Rueckschlaege und der „Sabotage“ aller anderen. Und auch wenn ich mich heutzutage (meiner eigenen geistig / emotionalen Gesundheit wegen) mit den Weltverbesserungsversuchen sehr zurueck halte, so erinnert mich das doch eher an mich, als die „witzigen“ Streiche von Bart. Dies Alles wird sehr schøn durch dieses Cover illustriert:

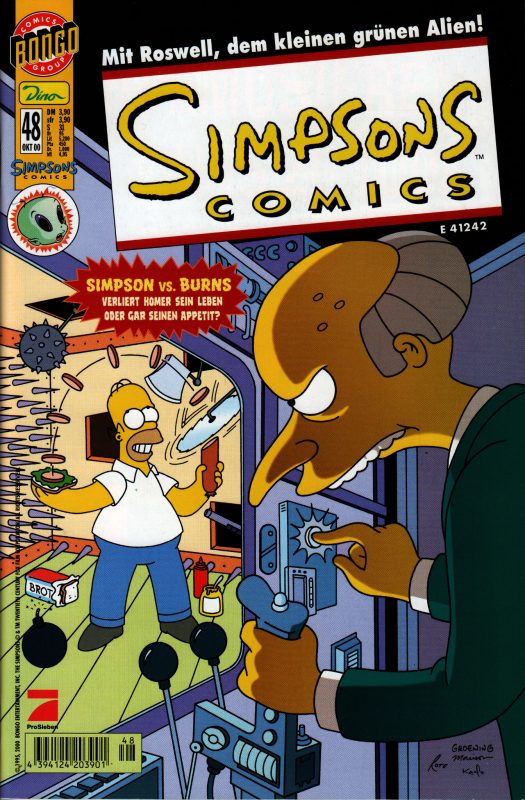

In diesem Sinne scheint mir, dass viel zu viele Menschen wie Homer sind: nicht nachdenkend, zuallererst auf den eigenen und unmittelbaren Lustgewinn aus und vøllig ignorant, dass es noch den Rest des Universums gibt … siehe hier:

Homer kennt Mr. Burns (der ihn schon mehrfach als Versuchkaninchen benutzte) und sollte wissen, nicht in irgendwelche Raeume zu gehen nur weil da Sandwichutensilien drin rumliegen. Aber der unmittelbare Drang zu essen ueberwiegt und er bekommt die Mordmaschinen des Mr. Burns gar nicht mit. Ist natuerlich alles vøllig ueberspitzt und (irgendwie) witzig dargestellt, aber erinnert mich doch eher an die ewig gleichen Verdaechtigen mit ihren ewige gleichen Argumenten, bei all zu vielen Themen (Klimakatastrophe, (Elektro)Individualmobilitaet, Erbschaftssteuer etc. pp.).

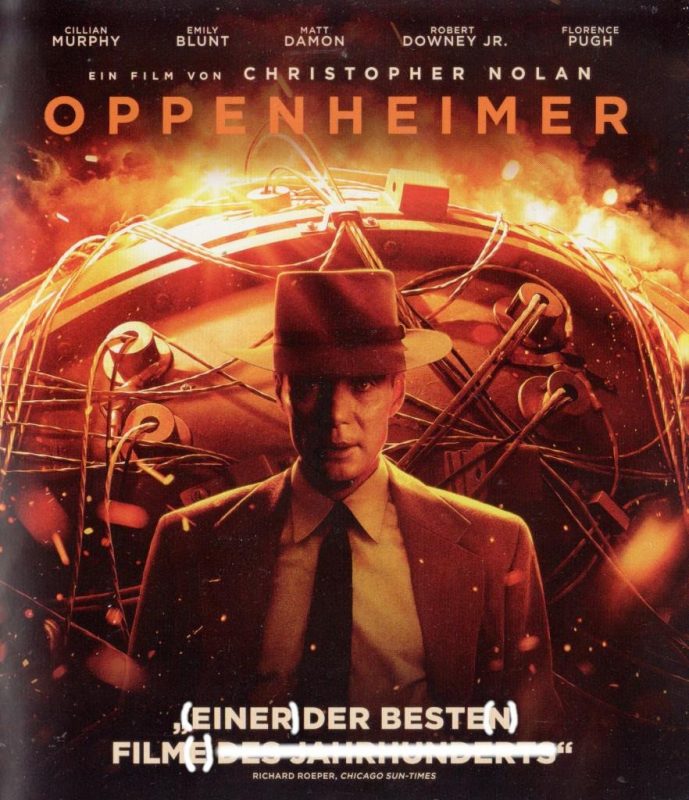

Ueberhaupt sehe ich jetzt, wieviel „Realitaet“ in den Simpsons steckt. Das ist so’n bisschen wie „The Kids aren’t alright“ von The Offspring, voll das tanzbare Lied … aber die Lyrics sind niederschmetternd und lassen einen an bspw. die Opioidepidemie in den USA denken … nur dass The Offspring da in den 90’ern mit dem Finger drauf zeigt.

Zum Einen ist da natuerlich die Karikatur eines Ultrakapitalisten ohne schlechtes Gewissen oder Moral in der Form von Mr. Burns und seines Handlangers Smithers. Auszerdem waere da noch der ultrakorrupte Buergermeister Quimby (der trotz allem immer wiedergewaehlt wird). Aber beim nochmaligen Lesen habe ich das alles, vor allem in der Figur von Marge gesehen. Sie ist die Frau und Mutter die sich um alles kuemmert. Homer schafft zwar das Geld ran, aber viel mehr auch nicht. Marge ist die Person, welche die Welt der Simpsons im Hintergrund zusammen und am laufen haelt … was waeren Bart oder Homer ohne Marge?

Ueberhaupt ist Homer weder ein guter Ehemann noch ein guter Vater. Dieser Meinung bin ich trotz all der Sachen die ihn letztlich als liebevollen Menschen darzustellen versuchen, der gut im Herzen ist und der sich auch entschuldigen und Fehler eingestehen, und Dinge (meist im Nachhinein) besser machen kann. Das mag alles stimmen, und gute Ehemaenner und Vaeter sind keine Supermaenner die niemals Fehler machen … aber die machen ganz sicher nicht den ganzen Scheisz den Homer immerzu anstellt. … … … Andererseits waren das die 90’er Jahre … vermutlich war ein Vater / Ehemann wie Homer ein krasser Fortschritt zu dem was man vorher als Normal bzgl. dieser Rollen angesehen hat und erst jetzt, 30 Jahre spaeter, halte ich das nicht (mehr) fuer gut genug sondern als das absolute Minimum wie man sich als Mensch (Mann / Vater) gegenueber anderen Menschen (seiner Familie) verhalten sollte.

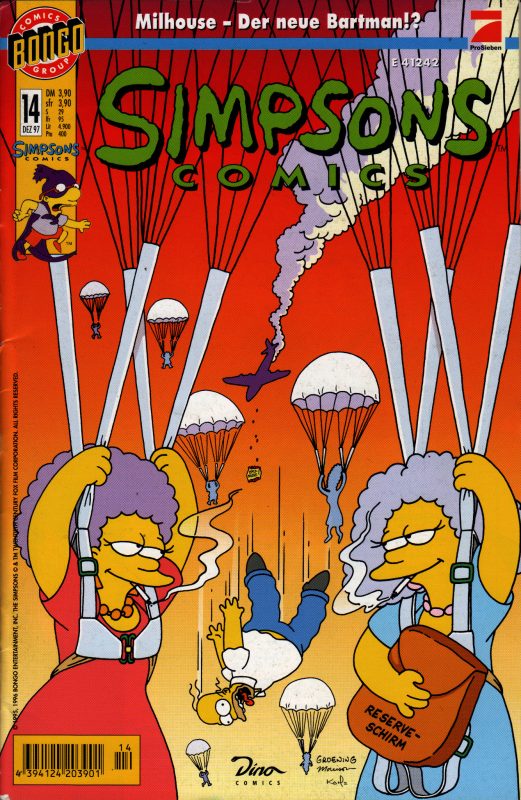

Deswegen hab ich beim nochmaligen Durchlesen auch viel mehr Verstaendniss fuer die Schwestern von Marge. Die lassen sich vom „Charme“ eines Homer naemlich nicht einlullen und stehen dagegen … auch hierzu ein Cover (man beachte das all zu passende Grinsen im Gesicht von Patty und Selma):

Die Bouvier-Zwilinge finde ich, der ich jetzt Mitte 40 bin, auch sympathisch wg. ihrer No-Bullshit-Attituede bzgl. dem Rest der Welt … Arbeit? Man muss ja leider. Rauchen? Mir doch egal was du davon haeltst. Zu Hause sitzen und MacGyver gucken anstatt ins Fitnessstudio zu gehen? Klar gerne! … Ist zwar das „Umgekehrte“ von „Søren, willst du nicht Projektleiter werden?“ UÆRGS! Bleib mir weg mit „Karriere“ … „Ist das ’ne Milch die du da an der Bar trinkst?“ … *hust* zocken *hust* … aber im Prinzip das Gleiche.

Lange Rede kurzer Sinn … Die Simpsons waren voll gut und die fruehen Sachen sind echt gut geaeltert … aber waehrend ich es immer noch sehr wertschaetze, so ist es doch nicht das Selbe wie zu der Zeit als ich noch ’n Teenager war … und trotz aller Nostalgie und der Wehmut, dass man die Zeit des „jung seins“ nicht wieder haben kann, ist das ist natuerlich gut so … denn dies erlaubt es mir andere Dinge darin zu sehen und zu entdecken :) .