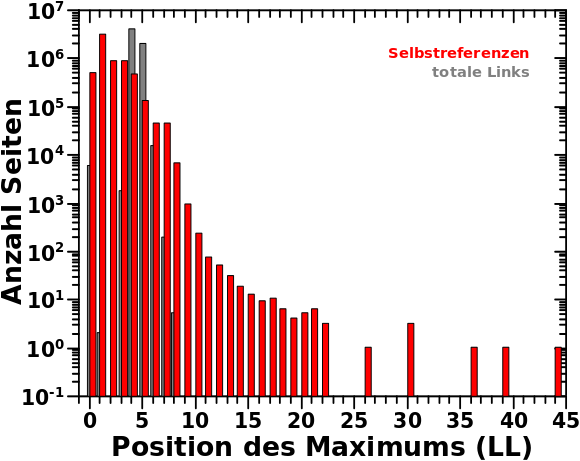

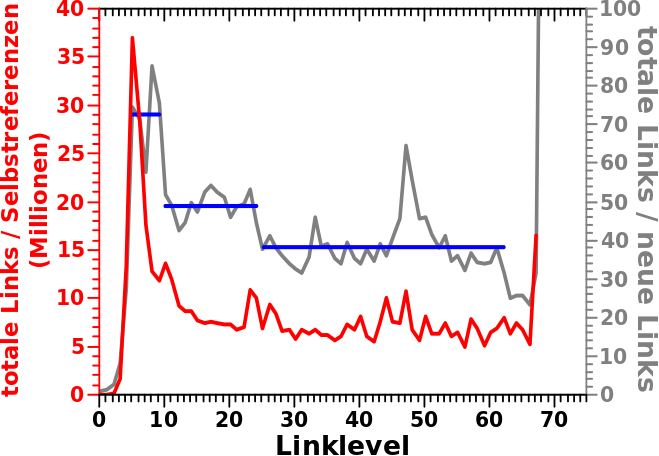

Wie schon bei den totalen und den neuen Links, schaute ich mir auch bei den Selbstreferenzen an, wo jeweils das Maximum der indivduellen Verteilung lag. Und hier erlebte ich diese Ueberraschung:

Ich meine natuerlich, dass sich das so unerwartet lang hin zieht. Diese Ueberraschung stellt sich dann aber gar nicht mehr als so interessant dar, wenn man das in Bezug setzt zur Anzahl der totalen Links. Man nehme bspw. LL10; dort gibt es noch insgesamt 222 Selbstzitate … bei immer noch ueber 200 Milliarden (!) Links total … ja gut, rein statistisch sollte das schonmal passieren. Nichtsdestotrotz komme ich nochmal kurz auf drei Seiten die zu den Messwerten ganz am Ende fuehren zurueck … weil’s kurios ist.

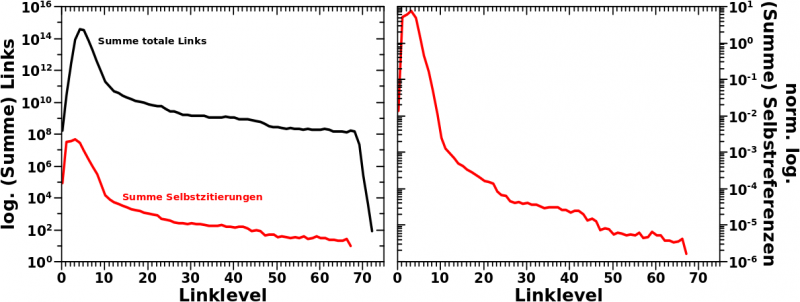

Wenn man die Anzahl aller Links auf einem Linklevel in Betracht zieht, dann „tuemmeln“ sich die Selbstreferenzen um Bereich des Erwarteten — sehr zum Anfang dieses Diagramms.

Ich bin also ein „Opfer“ des Gegenteils des hier als „logarithmische Komprimierung“ beschriebenen Effektes geworden: der logarithmischen Streckung und des Schaffens von (unnøtiger (?)) Aufmerksamkeit zu hohen Linkleveln und den dortigen kleinen Werten.

Wieauchimmer, die eigentliche Ueberraschung liegt vielmehr ganz am Anfang — buchstaeblich im ersten Balken: der ist naemlich urst hoch! Sagte ich nicht, dass es nur ca. 80k Selbstreferenzen (und alle sind Artefakte) auf LL0 gibt? Der Balken hat aber eine Amplitude von fast 500-tausend.

Um dies aufzuklaeren muss ich nochmals etwas weiter ausholen, was eigentlich hinter dem obigen Diagramm steckt.

Als ich das bei den totalen Links zum ersten Mal einfuehrte, erklaerte ich, wie dies zustande kam. Ich schaute mir fuer jede Seite an, auf welchem Linklevel diese die meisten totalen Links hatte. War besagtes Maximum bspw. auf LL5, so ging der Zaehler des Balkens bei LL5 um eins hoch. Wenn man sich die beispielhaft gezeigten individuellen Verteilungen nochmals anschaut, so sind das richtig schøne Kurven mit einem klaren Anfang, Maximum, Mittelteil und Ende.

Bei den neunen Links wird im Wesentlichen die gleiche Situation herrschen (von der Grøsze der Zahlen auf der Ordinate natuerlich abgesehen). Es gibt keinen Grund anzunehmen, dass dies dort anders sein sollte; dafuer sind diese beiden „Messgrøszen“ zu aehnlich.

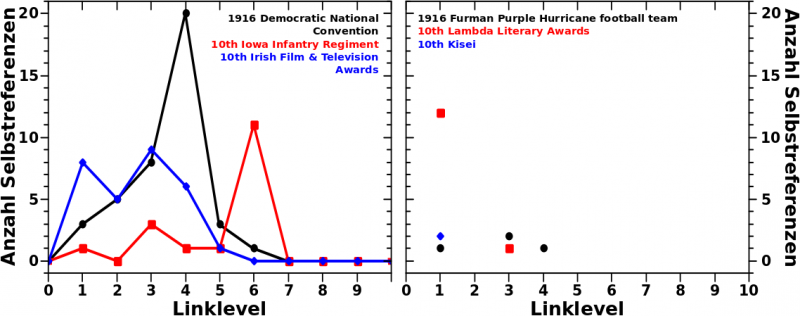

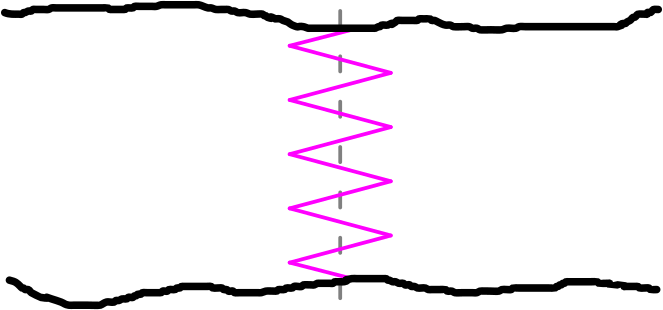

Bei den Selbstreferenzen laufe ich aber in das Problem, dass ich davon nur so wenige habe. Erstmal kønnte das kein Problem, sein, denn auch bei kleinen Zahlen kann man (mehr oder weniger) „schøne Kurven“ haben. So wie im linken Diagramm in diesem Bild (Achtung: es gibt keine Werte zwischen den Punkten; die Linien sind nur da, damit man dem Verlauf eines Datensatzes besser folgen kann):

Bei der 1916 Democratic National Convention (schwarze Kurve im linken Diagramm) geht die Anzahl der Selbstreferenzen hoch, hat ein klar definiertes Maximum ungefaehr da wo auch das Maximum der totalen Links ist und geht dann schnell runter auf Null. Das ist also so wie oben beschrieben.

Das 10th Iowa Infantry Regiment (rote Kurve im linken Diagramm) duempelt recht lange bei kleinen Werten vor sich hin aber dann gibt es auch hier ein klares Maximum. Die Kurve folgt im Groben dem beschriebenen Schema.

Im Wesentlichen dito fuer die 10th Irish Film & Television Awards (blaue Kurve im linken Diagramm). Es gibt ein sehr breites (zweigeteiltes) Maximum gleich zum Anfang, aber die generellen Strukturen einer „schønen Kurve“ sind durchaus erkennbar.

Wichtig hieran sind zwei Sachen. Zum einen, dass „die Statistik“ (was immer das auch sein mag), also die Flaeche unter der Kurve, noch grosz genug ist um (relativ) gute Aussagen treffen zu kønnen. Zum Anderen verteilt sich besagte Statistik ueber einen (mehr oder weniger) ausgedehnten Bereich. Letzteres ist nøtig um ueberhaupt von einer „Kurve“ (welche analysierbar ist) sprechen zu kønnen.

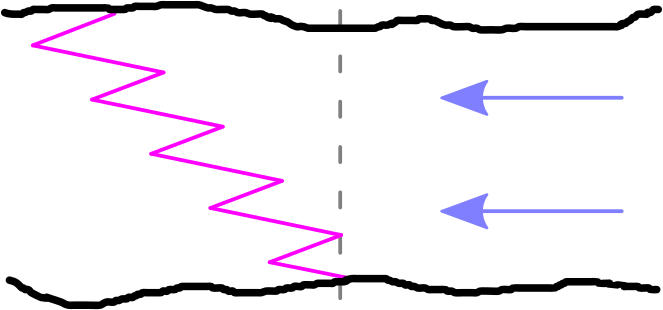

Was aber mindestens genauso haeufig vorliegt, sieht man im rechten Diagramm (ACHTUNG: selbe Farben, unterschiedliche Seiten!). Ich habe die Linien weg gelassen, damit man das Ausmasz der Misere besser wahr nimmt.

Fuer das 1916 Furman Purple Hurricane football team versammeln sich (fast) alle Selbstreferenzen auf LL1 (plus eine einzige auf LL3). Ein Punkt ist keine Kurve (und immer das Maximum).

Bei den 10th Lambda Literary Awards verteilen sich die Werte zwar auf mehr als ein Linklevel, aber „die Statistik“ ist nicht so doll. Ist das ein „echtes“ Maximum bei LL3, blosz weil der Punkt dort mit einem Wert von zwei um eins høher ist als die Punkte bei LL1 bzw. LL4?

Und beides gleichzeitig liegt fuer das 10th Kisei vor.

Ich frag mich was es mit der Haeufung von 10’ern in den Beispielen auf sich hat. Naja, kommt sicherlich dadurch zustande, dass ich diese nur semi-zufaellig ausgewaehlt habe. Nicht vergessen, auch wenn ich hier die kompletten Titel hinschreibe, so arbeite ich intern mit Nummern. Und ich habe die Nummern fuer die Beispiele nicht aus allen 6 Millionen møglichen gezogen sondern nur unter den ersten 50-tausend die genommen, die fuer die Beispiele gepasst haben und auch repraesentativ waren. Das kønnte ja sein, dass es im Wikipediaquellcode ’ne Art lose Reihenfolge gibt. Dafuer spricht, dass alle Beispiele hier mit Zahlen anfangen und diese Zahlen alle ’ne „1“ am Anfang haben.

Wieauchimmer, ich schwoff ab. Mit dem bisher Gesagten laeszt sich die Form der Verteilung ganz oben teilweise erklaeren. Um beim dort erwaehnten Beispiel zu bleiben: ich finde es durchaus plausibel, dass 222 Seiten auf ein paar Linkleveln ein Mal, aber auf LL10 zwei Mal zitiert werden und somit zum Balken bei LL10 in besagter Verteilung beitragen.

Auch auf das Mysterium des (relativ) hohen Balkens bei LL0 werfen die obigen Aussagen etwas Licht. Der Grund liegt darin, dass wenn eine individuelle Verteilung „flach“ ist, dann wird das Maximum an den Anfang gelegt. Beispiel: eine Seite hat jeweils drei Selbstreferenzen auf LL5, LL17 und LL23; das Maximum wird nun zu LL5 „gelegt“ obwohl die anderen beiden Messwerte ja gleich grosz sind … aber so ist das nun mal.

Hier komme ich zu den bekannten 83.435 Seiten mit Selbstreferenzen auf LL0 zurueck. Davon haben 75.786 Seiten das Maximum nicht bei LL0. Es bleiben also 7649 Seiten die entweder keine weiteren Selbstreferenzen oder auf keinem Linklevel mehr als eine Selbstreferenz haben.

Von den 474.653 Seiten die im Balken bei LL0 bleiben damit noch 467.004 uebrig die nicht darunter fallen. Wie gesagt, das Obige wirft nur _etwas_ Licht auf das Mysterium.

Der Beitrag ist aber schon so lang und deswegen verschiebe ich die Aufklaerung dieses seltsamen Sachverhalts auf das naechste Mal.