Heute gleich noch ein Beitrag in dieser Miniserie und ich muss etwas weiter ausholen.

Neugierde wird als eine notwendige Bedingung fuer natuerliche Intelligenz angesehen. Das Baby lernt krabbeln, weil es neugierig auf den Ball ist, der auszer Reichweite der kleinen Aermchen liegt. Viele Leute glauben, dass ich sehr intelligent bin, nur weil ich ’n paar Sachen weisz, weil ich mein Leben lang neugierig war und das Eine und Andere gelesen habe.

Es ist aber keine hinreichende Bedingung fuer die sehr limitierte Bedeutung von „Intelligenz“ die wir Menschen haben. Viele Tiere sind definitiv neugierig, es waren aber keine Delphine, die auf dem Mond gelandet sind. Tiere sind definitiv (!) intelligent, wir Menschen haben dafuer nur noch nicht das richtige (nicht nur) theoretische Rahmenwerk gefunden um das zu beschreiben.

Noch wichtiger wenn man ueber Neugier schreibt ist das Folgende: wenn man wirklich etwas lernt (also NICHT nur auswendig lernt fuer die Pruefung), dann behaupte ich, dass dies immer aus intrinsischer Motivation heraus erfolgt. Und intrinsische Motivation hat man, weil man auf etwas neugierig ist. Oft (meistens?) ist man sich dieser Verbindung nur nicht bewusst.

Intrinsisch motiviert (und damit neugierig) zu sein ist die Grundlage all dessen wie man sich die als Welt erklaert — das persønliche Weltbild. Dieses Weltbild bestimmt (direkt und indirekt), wir wir an unser Leben heran gehen und (intellektuell, emotional und spirituell) wachsen. Wenn wir mit anderen Menschen „wechselwirken“ drueckt sich unser Weltbild in den allermeisten Faellen darin aus, wie wir auf Fragen antworten. Das ist jetzt zwar sehr spezifisch, aber im Allgemeinen will ich genau darauf hinaus! Von wirklich intelligenten Menschen wird man selten ein „das ist genau so und nicht anders“ høren. Dies liegt daran, dass diese oft so neugierig ueber etwas sind, dass sie auch Sachen lesen / anhøren / anschauen, die nicht in ihr (urspruengliches) Weltbild pass(t)en. Dadurch lernt man oft (meistens?) eine gegenteilige Meinung zu verstehen.

Ein paar Beispiele:

– Ich finde die Nazis zum kotzen und deren Meinungen sind in meinem Weltbild definitiv falsch und verabscheuungswuerdig … aber bei allem wie die westliche Welt sich vielerorts entwickelt hat, kann ich verstehen, warum Menschen sich dieser Ideologie zuwenden.

– Ich kann anerkennen, ja sogar verstehen, wenn Individuen sie tief bewegende, persønliche Erfahrungen mit der Offenbarung einer Gøttin in Verbindung bringen. In deren Weltbild stimmt das. In meinem Weltbild hat deren Gehirn auf eine ungewøhnliche Art reagiert.

– Ein Teilchen kann nicht durch eine feste Wand gehen … im Wellenbild ist die Chance, dass es pløtzlich auf der anderen Seite der Wand erscheint grøszer als Null. Nein, das øffnet nicht die Tore fuer Geistererscheinungen.

– In den letzten Jahren bin ich sehr zurueckhaltend geworden, wenn jemand meint, dass ich etwas gesagt (oder getan) haette, von dem ich ueberzeugt bin, dass ich das nicht gesagt (oder getan) habe. Meistens denke ich, dass sich dieser oder diese Jemand falsch erinnern muss. Ich habe aber gelernt, dass es so viele Sachen gibt, bei denen ich mich nicht an die Details erinnere, dass ich einraeume, dass besagter Jemand Recht haben kønnte.

Hinter all dem stehen (oft langjaehrige!) Lernprozesse, die nicht nur direkt auf eine konkrete Sachen ausgerichtet waren, sondern auch „Wege abseits“ des direkten Zielpfades „gegangen“ sind. Letzteres trotzdem dies (in den allermeisten Faellen) nicht „belohnt“ wird, auszer, dass meine Neugier befriedigt wird … was natuerlich ein Widerspruch ist, denn dies ist natuerlich ein enorme, wenn auch „nur“ interne, Belohnung.

Und damit komme ich zu kuenstlichen „Intelligenzen“ und ich werde im Folgenden aus diesem Artikel zitieren. Der Artikel selber beschreibt eine sehr spezifische Methode Computer neugierig zu machen, aber das ist nicht von Interesse, denn es geht mir nur um’s Prinzip.

In kurz: im Allgemeinen hat die Mehrheit der Bevølkerung (wenn ueberhaupt) die Vorstellung, dass kuenstliche „Intelligenzen“ (mehr oder weniger) zielorientiert trainiert werden mit (mehr oder weniger) direkter Rueckmeldung.

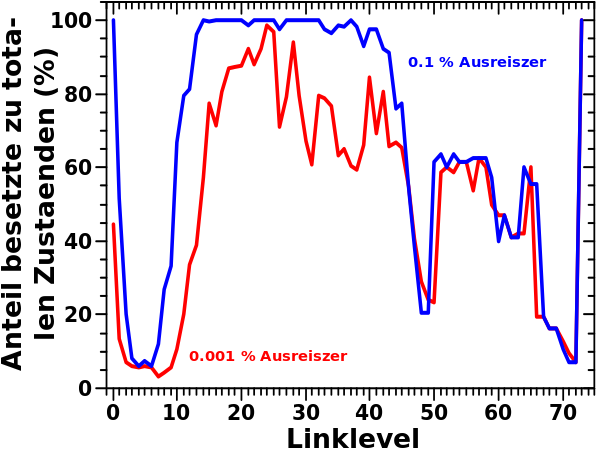

Learning goal-directed behavior with sparse feedback from complex environments is a fundamental challenge for artificial intelligence. Learning in this setting requires the agent to represent knowledge at multiple levels of spatio-temporal abstractions and to explore the environment efficiently.

Weiterhin ist …

[l]earning and operating over different levels of temporal abstraction […] a key challenge in tasks involving long-range planning.

Und deswegen werden kuenstliche „Intelligenzen“ von der besagten Mehrheit der Bevølkerung nicht ernst genommen, denn dafuer braucht man interne Motivation. „Seitenwege“ muessen erkundet werden um Problemstellungen in einen grøszeren Zusammenhang zu bringen. Dies ist (per definitionem) nicht direkt zielfuehrend. Eine Rueckmeldung darob des „Erfolgs“ dieser „Erkundung“ wuerde also eher negativ ausfallen. Oder anders:

The nature and origin of ‘good’ intrinsic reward functions is an open question in reinforcement learning.

Ach so, das gilt natuerlich nicht nur fuer Maschinen, sondern auch bei Menschen ist …

[t]he nature and origin of intrinsic goals […] a thorny issue.

Im Artikel werden ein paar Dinge zitiert, wie dieses Problemen einer intrinsischen Motivation angegangen werden kann. Neben dem im Artikel detailliert besrpochenen, ganz konkreten Konzept (nicht so wichtig, siehe oben) laeuft dies im Allgemeinen auf Sachen wie …

[…] the effectiveness of artificial curiosity using information gain maximization […]

… oder …

[…] the improvements to a predictive world model made by the learning algorithm […]

hinaus.

Wieauchimmer es gemacht wird, im wesentlich faellt dies unter sogenannte Meta (oder auch Mesa) Optimierer — etwas anderes als die direkte Zielfuehrung wird optimiert. Mesa-Optimierung stellt ein ernstes Problem dar, wenn man ganz sicher gehen will, dass Skynet die Menschheit nicht ausløscht … ein _sehr_ ernstes Problem, denn Ultron wollte genau dies tun, nachdem es nur 10 Minuten im Internet verbracht hatte … okok, zugegebenermaszem ist das beim heutigen Internet eine natuerliche Reaktion.

Deswegen wie immer: nur weil Computer etwas bisher nicht konnten, heiszt das noch lange nicht, dass das fuer immer so bleiben wird. Dabei ist insbesondere zu bedenken, dass der verlinkte Artikel bereits von 2016 ist und seitdem ganz viel auf diesem Gebiet passiert ist … siehe GPT-3, oder DALL-E (dazu vielleicht lieber das hier), bei denen man nicht umhin kommt sich zu fragen, wie denn die interne Repraesentation der Welt, dieser kuenstlichen „Intelligenzen“ aussieht und wie diese das erlernt haben.

Aber genug fuer heute. Dieser Beitrag ist lang genug und ich schaffe es leider nicht, dieses Konzept und worauf ich hinaus will konkreter (und besser) zu beschreiben :(